DATALEARN | DE - 101 | МОДУЛЬ 7-4 ЗНАКОМСТВО С SPARK API

В этом модуле мы познакомимся еще ближе с Apache Spark.

В этом видео вы узнаете про:

📌 что такое RDD (Resilient Distributed Datasets)

📌 что такое DataFrame

📌 посмотрим на пример синтаксиса Scala vs Python

📌 типы данных Spark

📌 схему(schema) dataframe

📌 колонки (colums) и вычисляемы (expressions) поля dataframe

📌 основные операции при работе с dataframe (Reader, Wrtiter)

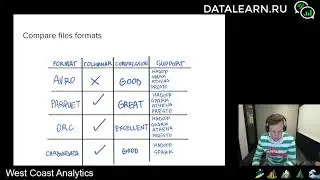

📌 примеры чтения разных источников и файлов (API, база данных, JSON, Parquet, CSV, TXT)

📌 различные операции для трансформации, фильтрации и агрегации данных в Spark DataFrame (прям как в SQL)

📌 Spark SQL, Catalyst Optimizer

📌 план запроса Spark

📌 примеры advance Spark функций и ноутбуков в Databticks

В качестве лаборатнорной работы мы будем анализировать данные по пожарной службе Сан-Франциско. Я покажу, как можно прочитать файл и выполнить просты запросы на PySpark.

Так же мы посмотрим на курс от Databricks про Apache Spark Developer. Мы посмотрим лишь, часть, которая относится к этой лекции:

📌 Reader & Writer

📌 DataFrame & Column

📌 Aggregations

📌 Datetime functions

📌 Complex Types

📌 Additional Spark Functions

=====

В 7м модуле мы познакомимся с open source решением для аналитики и инжиниринга данных - Apache Spark и его коммерческой версией Databricks и аналгоми Amazon Glue и Azure Synapse. Вы узнаете примеры использования в индустрии и популярные use cases. Я расскажу о своем опыте с Apache Spark в Амазоне и Майкрософт и научу вас работать с данными с помощью PySpark и Spark SQL, покажу вам лучшие книги и материалы по Spark.

🔔 Подписывайтесь на канал "Datalearn" чтобы не пропустить остальные части и ставьте лайки!

📕 Записывайтесь и проходите курс Инженера Данных.

⚠️ КУРС БЕСПЛАТНЫЙ!

🔗 Записаться вы можете на нашем портале https://datalearn.ru/

👍🏻 Запись на курс даст вам возможность не только просматривать видео, но и получить доступ к закрытым материалам, а также возможность выполнять домашние задания и получить сертификат прохождения курса.

🔥Самые актуальные новости про аналитику в Telegram канале: https://t.me/rockyourdata

![Spider-Man Web Of Shadows [PART 3] [LUKE CAGE GÖREVLERİ]](https://images.videosashka.com/watch/f8WpdUq2T24)